·PaLM-E是迄今為止已知的最大VLM(視覺語言模型)。作為一種多模態具身VLM,它不僅可以理解圖像,還能理解、生成語言,執行各種復雜的機器人指令而無需重新訓練。它還展示出了強大的涌現能力(模型有不可預測的表現)。

·通過將PaLM-E集成到控制回路中,它可以抵抗任務期間可能發生的中斷。在一個視頻示例中,研究人員從機器人手中抓取薯片并移動它們,但機器人找到薯片并再次抓取它們。

“距AGI(通用人工智能)的問世不會太遙遠,不過過程中肯定會出現許多誤判。預計在未來五年時間里,AI能夠在大多數人類目前從事的工作上表現得比人類更好。”在ChatGPT發布前一個月,OpenAI聯合創始人、ChatGPT項目的主要負責人JohnSchulman在強化學習播客《TalkRL》上說道。

AGI似乎并不遙遠,但對于如何通向AGI,目前研究者都還在探索。就在近日,一個新的研究成果發布——用視覺數據來增強語言處理能力。它的表現令人驚喜,展示出了強大的涌現能力(模型有不可預測的表現)。

北京時間3月7日,谷歌和柏林工業大學的團隊重磅推出了史上最大的視覺語言模型——PaLM-E,參數量高達5620億(GPT-3的參數量為1750億)。

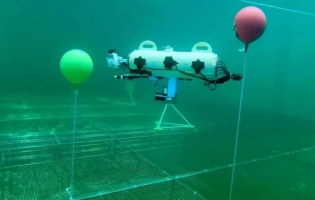

PaLM-E的應用示意。“PaLM-E是迄今為止已知的最大VLM(視覺語言模型)。我們觀察到諸如多模態思維鏈推理(允許模型分析包括語言和視覺信息的一系列輸入),只接受單圖像提示訓練的多圖像推理(使用多個圖像作為輸入來做出推理或預測)等涌現能力。”論文的第一作者、谷歌AI研究員DannyDriess說。

論文的第一作者、谷歌AI研究員DannyDriess的推文。在這個意義上,隨著時間推移,深度學習模型變得越來越復雜,PaLM-E似乎延續了“產生驚喜”的這個趨勢。

PaLM-E(PathwaysLanguageModelwithEmbodied)是PaLM-540B語言模型與ViT-22B視覺Transformer模型的結合。它被稱為“PaLM-E”是因為它基于谷歌現有的“PaLM”大語言模型(類似于ChatGPT背后的技術)。谷歌通過添加感官信息和機器人控制,使PaLM“具身化(embodiment,與身體聯系緊密的狀態)”。由于它基于語言模型,PaLM-E會進行連續觀察,例如圖像信息或傳感器數據,并將它們編碼為一系列與語言標記大小相同的向量。這允許模型以與處理語言相同的方式“理解”感官信息。PaLM-E還借鑒了谷歌之前在ViT-22B視覺Transformer模型上的工作,ViT-22B已經接受過各種視覺任務的訓練,例如圖像分類、對象檢測、語義分割和圖像字幕。

谷歌并不是唯一一個致力于使用神經網絡進行機器人控制的研究小組。這項特殊的工作類似于微軟最近的“ChatGPTforRobotics”論文,該論文嘗試以類似的方式將視覺數據和大型語言模型結合起來進行機器人控制。

作為一種多模態具身視覺語言模型(VLM),PaLM-E不僅可以理解圖像,還能理解、生成語言,可以執行各種復雜的機器人指令而無需重新訓練。

機器人被要求去抽屜里拿薯片。根據谷歌的說法,當給出一個高級命令時,比如“把抽屜里的薯片拿給我”,PaLM-E可以為一個有手臂的移動機器人平臺(由谷歌機器人開發)生成一個行動計劃并執行自己的行動。PaLM-E通過分析來自機器人相機的數據來實現這一點,而無需對場景進行預處理。這消除了人類預處理或注釋數據的需要,并允許更自主的機器人控制。它還具有彈性,可以對環境做出反應。例如,PaLM-E模型可以引導機器人從廚房取薯片袋,而且,通過將PaLM-E集成到控制回路中,它可以抵抗任務期間可能發生的中斷。在一個視頻示例中,研究人員從機器人手中抓取薯片并移動它們,但機器人找到薯片并再次抓取它們。

在另一個示例中,相同的PaLM-E模型通過具有復雜序列的任務自主控制機器人,這些任務以前需要人工指導。谷歌的研究論文解釋了PaLM-E如何將指令轉化為行動:

我們展示了PaLM-E在具有挑戰性和多樣化的移動操作任務上的性能。機器人需要根據人類的指令規劃一系列導航和操縱動作。例如,給出指令“我把飲料弄灑了,你能給我拿點東西來清理嗎”,機器人需要規劃一個包含“1.找到海綿,2.撿起海綿,3.拿來,4.放下海綿”的序列給用戶。受這些任務的啟發,我們開發了3個用例來測試PaLM-E的具身推理能力:可供性預測、故障檢測和長期規劃。

PaLM-E識別圖像中的籃球明星科比·布萊恩特,并可以生成關于他的文本信息,比如他贏得了多少次冠軍。研究人員寫道,PaLM-E也是一種“有效的視覺語言模型”。例如,它可以識別圖像中的籃球明星科比·布萊恩特,并可以生成關于他的文本信息,比如他贏得了多少次冠軍。在另一個例子中,PaLM-E看到一個交通標志并解釋與之相關的規則。

PaLM-E看到一個交通標志并解釋與之相關的規則。除了機器人技術,谷歌研究人員還觀察到一些有趣的效果,這些效果顯然來自PaLM-E的核心——大型語言模型。PaLM-E表現出了“正遷移”能力,即它可以將從一項任務中學到的知識和技能遷移到另一項任務中,從而與單任務機器人模型相比具有“顯著更高的性能”。

語言模型越大,在視覺語言和機器人任務訓練時就越能保持其語言能力。此外,他們還觀察到模型規模的趨勢:“語言模型越大,在視覺語言和機器人任務訓練時就越能保持其語言能力——從數量上講,562BPaLM-E模型幾乎保留了其所有的語言能力。

谷歌研究人員計劃探索PaLM-E在現實世界場景中的更多應用,例如家庭自動化或工業機器人。他們希望PaLM-E能夠激發更多關于多模態推理和具身AI的研究。

“多模態”已成為一個流行語,我們可能會越來越多地聽到這個詞。因為很多公司正在研發看起來能夠像人類一樣執行一般任務的通用人工智能。