試想一下:當有人將一張“神奇的貼紙”放置在面部,就能使人臉識別門禁系統誤認為是你,從而輕而易舉打開大門;同樣是這張“神奇的貼紙”,把它放置在眼鏡上,就可以1秒解鎖你的手機人臉識別,探取你的隱私如入“無人之境”。

這樣的景象,并不是科幻電影中的想象,而是《中國經營報》記者從9月16日舉行的AISC首屆人工智能安全大賽現場所看到的真實攻防場景。

人工智能在快速發展的同時,也帶來了一些新的風險和隱患。人工智能安全是人工智能生態體系中的重要組成部分,關系到社會經濟生活的方方面面,是我國數字經濟高質量發展的重要支撐與基礎保障。基于此,由國家工業信息安全發展研究中心、清華大學人工智能研究院和AI技術企業瑞萊智慧等聯合舉辦了人工智能安全大賽,這是國內首個全國性的人工智能安全賽事,其目的在于推動人工智能技術創新、實戰演練、場景挖掘和人才培養等。

瑞萊智慧CEO田天明確指出,人工智能技術風險發生的范圍正隨著應用場景的日趨廣泛而逐步擴大,風險發生的可能性也隨著其應用頻次的增長而持續提高。統籌做好人工智能發展與安全已成為當務之急。

AI安全并非未來挑戰,而是眼前威脅

“人工智能當前的安全風險,主要可以從‘人’與‘系統’這兩個視角來剖析。”田天如是表示。從人的視角來評估AI的安全問題,首先就是技術的兩面性問題——存在AI技術濫用甚至“武器化”的問題。具體到人工智能的應用中來看,最為典型的代表就是“深度偽造技術”,其負向應用風險持續加劇且已產生實質危害。

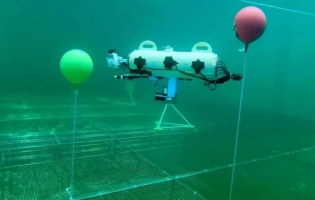

田天進一步解釋說,現場使用“神奇的貼紙”破解人臉識別所揭示的正是“系統”的風險,它來自于深度學習算法本身的脆弱性。以深度學習算法為核心的第二代人工智能是個“黑盒子”,具有不可解釋性,這意味著系統存在結構性的漏洞,可能遇到不可預知的風險。“神奇的貼紙”實際就是“對抗樣本攻擊”,即通過在輸入數據中添加擾動,使得系統作出錯誤判斷。

尤其值得注意的是,這一漏洞在當前大火的自動駕駛感知系統中同樣存在。瑞萊智慧相關人員在現場還演示了用對抗樣本攻擊自動駕駛汽車的情況。記者觀察到,在正常情況下,當攝像頭識別到路障、指示牌、行人等目標后,自動駕駛車輛就會立即停車,但是如果在目標物體上添加干擾圖案后,車輛的感知系統就會出錯,徑直撞上去。

多方探索AI安全建設的新路徑

統籌發展和安全,是每項新技術發展過程中面臨的必然問題,如何實現高水平發展和高水平安全的良性互動,也是當前人工智能產業發展很重要的命題,現場多位專家就此話題展開分享,探索AI安全建設的新思路與新路徑。

人工智能對抗攻防包括對抗樣本、神經網絡后門、模型隱私問題等多方面技術。模型有錯誤就需要進行及時的修復,中國科學院信息安全國家重點實驗室副主任陳愷提出了“神經網絡手術刀”的方法,通過定位引發錯誤的神經元,進行精準“微創”修復。陳愷指出,不同于傳統的模型修復工作需要重新訓練模型,或者依賴于較大量的數據樣本,這種方式類似于“微創手術”,只需極少量或無須數據樣本,就能夠大幅提升模型修復效果。

工商銀行金融研究院安全攻防實驗室主管專家蘇建明則表示,人工智能安全治理需要廣泛協作和開放創新,需加強政府、學術機構、企業等產業各參與方的互動合作,建立積極的生態規則。政策層面,加快人工智能的立法進程,加強對人工智能服務水平、技術支撐能力等專項監督考核力度。學術層面,加大對人工智能安全研究的激勵投入,通過產學研合作模式加快科研成果的轉化與落地。企業層面,逐步推動人工智能技術由場景拓展向安全可信發展轉變,通過參與標準制定,推出產品服務,持續探索人工智能安全實踐及解決方案。

通過比賽加速培育AI安全新型人才

中國科學院院士、清華大學人工智能研究院名譽院長張鈸指出,構建下一代人工智能,實現安全、可信、可靠、創新發展,需要融合知識、數據、算法、算力四個要素,對技術及功能持續地進行推演和實驗,而舉辦人工智能安全大賽顯然是一個有效的途徑和方法。

記者獲悉,本次人工智能安全大賽自7月啟動以來,共吸引來自全國70多所高校、科研院所、企業等超過400支團隊參與,選手共計600余名。經過3個月的角逐,由上海交通大學聯合戰隊“AreYouFake”與北京交通大學戰隊“BJTU-ADaM”分別摘得深度偽造安全與自動駕駛安全賽道第一名,北京理工大學戰隊“DeepDream”與建信金科戰隊“TianQuan&LianYi”共同位列人臉識別賽道第一名。

田天認為,構建人工智能的安全生態,一方面需要技術的持續演進,一方面也需要專項技術人才的建設與培養。由于人工智能安全研究目前仍屬于新興領域,專項人才較少,缺乏系統性的研究隊伍,本次大賽通過實戰演練的方式,全方位驗證和提升選手實戰能力,為培育一批高水平、高層次的人工智能安全新型人才團隊提供了“快速通道”。