近日,美國機器人領域的創新企業Figure AI發布了一項重大突破:一款名為Helix的通用型視覺語言動作(VLA)模型。這款模型首次實現了對人形機器人完整上半身的高速連續控制,將感知、語言理解與學習控制完美融合。

Helix模型的問世,標志著人形機器人在操作靈活性上邁出了重要一步。用戶只需發出簡單的自然語言指令,無需任何事先演示或定制編程,機器人便能輕松抓取幾乎所有家庭小物件,即便是那些訓練時從未接觸過的物品也不在話下。這一能力得益于Helix模型強大的物體泛化能力。

Figure發布VLA模型Helix:一句話指令,人形機器人協作干家務

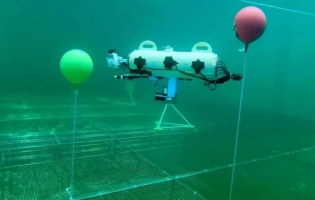

Figure AI強調,Helix模型創造了多項業界首次成就。它首次實現了對仿人機器人完整上半身的高速連續控制,包括手腕、軀干、頭部及每根手指的靈活操控。在測試中,機器人成功處理了數千件雜亂無章的新物品,從玻璃器皿、玩具到工具和衣服,均無需事先演示或編程。

Figure發布VLA模型Helix:一句話指令,人形機器人協作干家務

更令人驚嘆的是,Helix模型還具備多機器人協作能力。在測試中,兩臺機器人能夠協同完成長期復雜任務,共同處理從未見過的物品,如合作整理陌生雜貨。這種能力為機器人在家庭環境中的實際應用提供了更多可能性。

Figure發布VLA模型Helix:一句話指令,人形機器人協作干家務

Helix模型還展現了出色的場景理解與語義解析能力。當提示“撿起沙漠物品”時,機器人不僅能夠識別出玩具仙人掌符合這一抽象概念,還能選擇最近的手并執行精確的抓取動作。這種從語言到動作的通用抓取功能,為非結構化環境中部署人形機器人提供了更大的便利。

Figure發布VLA模型Helix:一句話指令,人形機器人協作干家務

Helix模型之所以能夠實現這些突破,得益于其開創性的雙系統架構。該架構由系統1和系統2組成,分別負責高速精準控制和場景理解與語義解析。系統2基于7B參數的開源VLM,以7-9Hz頻率運行,確保跨物體、跨場景的泛化能力。而系統1則是一個80M參數的視覺運動策略模型,以200Hz頻率將系統2的語義表征轉化為連續動作指令,實現毫秒級實時響應。這種解耦架構使得兩個系統能夠各司其職,共同實現高效的人形機器人控制。

Figure發布VLA模型Helix:一句話指令,人形機器人協作干家務

Helix模型在訓練過程中使用了極少的資源。團隊僅使用了約500小時的高質量監督數據,便實現了強大的物體泛化能力。這些數據僅占先前收集的視覺語言動作(VLA)數據集規模的5%不到,且無需依賴多機器人實體收集或多階段訓練。這一成果不僅展示了Helix模型的高效性,也為未來人形機器人的發展提供了更多可能性。