字節跳動旗下的Seed團隊在7月22日宣布了兩項重要成果:一款名為GR-3的高性能視覺語言動作(VLA)模型,以及一款與之配套的通用雙臂移動機器人ByteMini。這兩款產品的發布,標志著Seed團隊在機器人智能化領域邁出了重要一步。

GR-3模型的最大亮點在于其卓越的泛化能力。與以往需要大量機器人軌跡數據訓練的VLA模型不同,GR-3僅需少量人類數據即可實現高效微調,迅速適應新任務和新物體。這意味著,GR-3能夠快速“學習”并理解包含抽象概念的語言指令,從而在復雜多變的環境中展現出強大的適應性。GR-3還能精細地操作柔性物體,這一能力在以往的VLA模型中并不常見。

GR-3在處理長程任務和高靈巧度操作方面也表現出色。這得益于其改進的模型結構,使得GR-3能夠同時處理雙手協同操作、柔性物體操作以及融合底盤移動的全身操作等多種復雜任務。這種多任務處理能力,使得GR-3在實際應用中具有更高的靈活性和實用性。

為了實現GR-3的這些能力,Seed團隊采用了一種多樣的模型訓練方法。他們不僅收集了遙操作機器人獲取的高質量真機數據,還通過用戶授權征集了基于VR設備的人類軌跡數據,以及公開可用的大規模視覺語言數據。這些多樣性數據的融合,為GR-3的訓練提供了豐富的“營養”,使其能夠在復雜多變的環境中快速學習和適應。

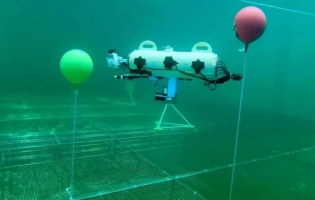

而與GR-3配套的ByteMini機器人,則是一款高靈活性、高可靠性的通用雙臂移動機器人。這款機器人專為GR-3設計,搭載了無偏置7個自由度機械臂和22個自由度全身運動系統。機械臂手腕采用球形設計,能夠在狹小空間內完成各種精細操作。同時,ByteMini還搭載了多顆攝像頭和全身運動控制系統(WBC),使其能夠高效地在真實環境中處理復雜任務。

在實際應用中,GR-3和ByteMini的組合展現出了驚人的表現。在超長序列的餐桌整理任務中,GR-3能夠高魯棒性、高成功率地完成任務,并嚴格遵循人類分步指令。在復雜靈巧的掛衣服任務中,GR-3能夠控制雙臂協同操作可形變柔性物體,并魯棒識別并整理不同擺放方式的衣服。在各類物體抓取放置任務中,GR-3能夠泛化到抓取未見過的物體,并理解包含復雜抽象概念的指令。

從技術層面來看,GR-3采用了MoT的網絡結構,將“視覺-語言模塊”和“動作生成模塊”結合成了一個40億參數的端到端模型。這種結構使得GR-3在處理復雜任務時更加高效和準確。同時,GR-3的數據訓練方法也突破了傳統機器人的局限,采用了三合一數據訓練法,從多種數據源中學習知識,進一步提升了其泛化能力和適應性。