火遍全球的大語言模型,已經Out了?

本次版本更新的主角是谷歌DeepMind推出的「視覺-語言-動作」(vision-language-action,VLA)模型!

論文地址:https://robotics-transformer2.github.io/assets/rt2.pdf

根據谷歌內部披露,VLA模型已經接入到機器人身上,能夠和現實世界進行互動了!

這個機器人被谷歌命名為Robotic Transformer 2 (RT-2) ,它能夠從網絡、機器人的數據中學習,還能將這些知識自主轉化為有效的指令。

簡單來說,你只需要對RT-2畫個餅,之后就可以等著RT-2把餅喂到你嘴邊了。

網友們紛紛表示:這真是泰酷辣!

谷歌DeepMind負責人表示,

長期以來,計算機在分析數據等復雜任務方面表現出色,但在識別和移動物體等簡單任務方面卻不盡如人意。通過 RT-2,我們正在縮小這一差距,幫助機器人解讀世界并與之互動,讓其對人類更加有用。

但俗話說,一口吃不成個大胖子,在RT-2成為RT-2之前,它的前輩Robotic Transformer 1 (RT-1)為RT-2打下了堅實的基礎。

RT-1升級RT-2,VLM到VLA

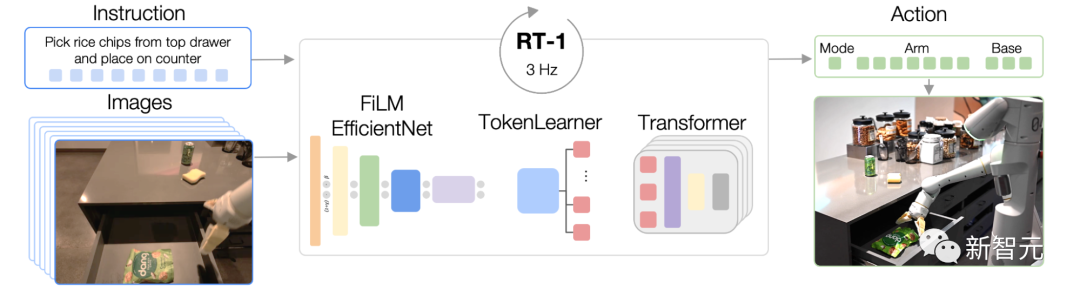

RT-1是一種多任務模型,基于Transformer構建,能夠將圖像、自然語言指令等作為輸入,并直接輸出標記化動作。

RT-1 的架構:該模型采用文本指令和圖像集作為輸入,通過預先訓練的 FiLM EfficientNet 模型將它們編碼為token,并通過 TokenLearner 壓縮它們。然后將這些輸入到 Transformer 中,Transformer 輸出操作token

因此,與一般機器相比,RT-1具有更好的性能和泛化能力。

其中,RT-1所搭載的視覺語言模型(vision-language models ,VLMs)扮演了關鍵角色。

VLM在互聯網級的數據集上進行訓練,因此在識別視覺、語言和跨語言合作這塊具有極高水平。

在RT-1基礎上升級過的RT-2仍以VLM 為基礎,是谷歌研究員在辦公室、廚房等環境中使用13個RT-1的17個月數據上進行訓練的。

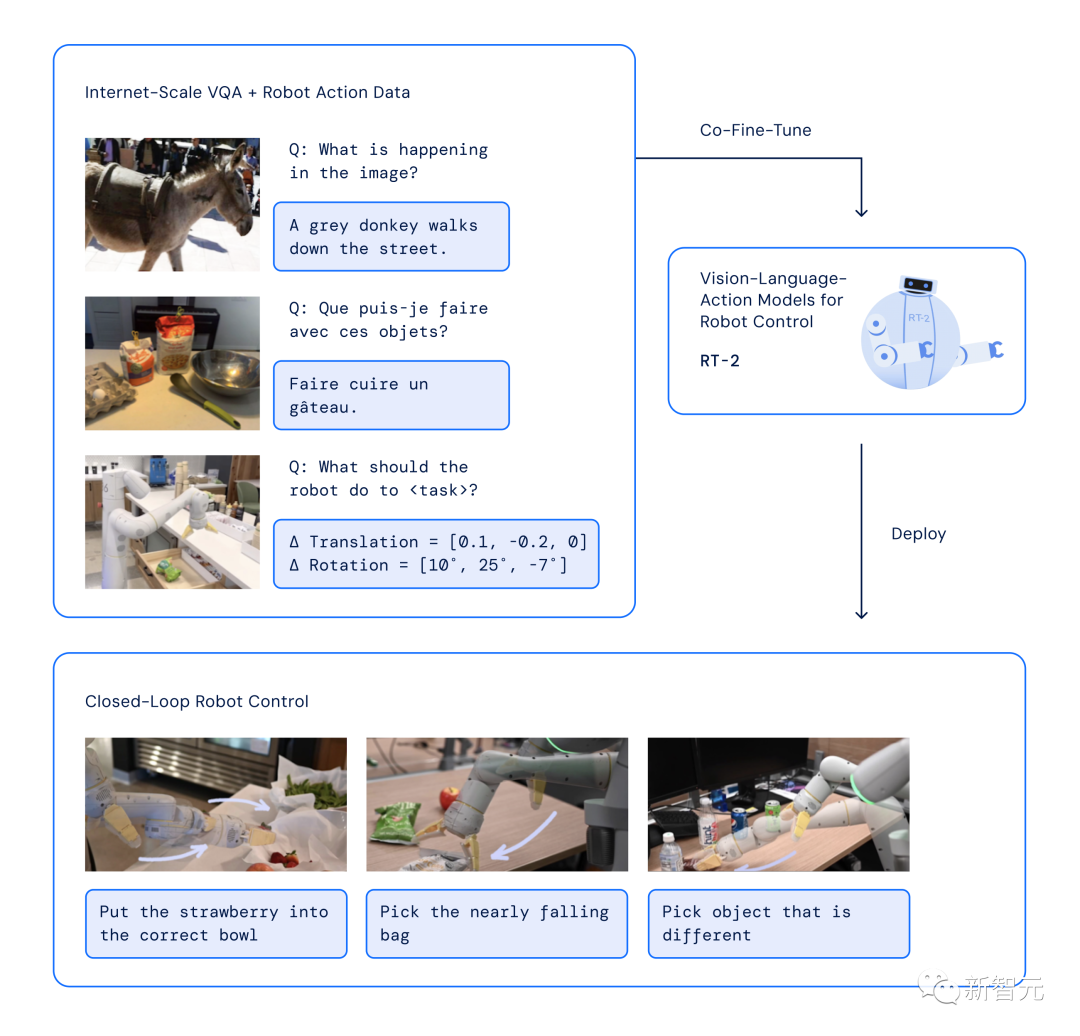

但RT-2比RT-1多了一個機器動作(action)的模態。

為了解決模型對機器控制的挑戰,研究人員將RT-2的機器操作設置為模型的輸出標記,并將其描述為可以由標準自然語言標記器處理的字符串,如下所示:

RT-2 訓練中使用的動作字符串的表示形式。這種字符串的示例可以是機器人動作標記編號的序列,例如「1 128 91 241 5 101 127 217」

于是,解決加入動作模態(action)將模型與機器進行聯結的挑戰后,VLM就升級為了VLA。

RT-2也在一系列的升級換代后,顯示出了驚人的學習能力和理解能力:

它能夠自己解釋全新的命令,通過執行基本推理來響應用戶的要求。

甚至在與思想鏈推理結合的情況下,RT-2能夠執行多階段的語義推理。

如,決定哪個物體可以用作臨時的錘子(石頭),或者哪種類型的飲料最適合疲倦的人(一種能量飲料)。

RT-2架構和訓練:針對機器人和網絡數據共同微調預訓練的VLM模型。生成的模型接收機器人看到的圖像并直接預測機器人要執行的動作

泛化能力提升62%

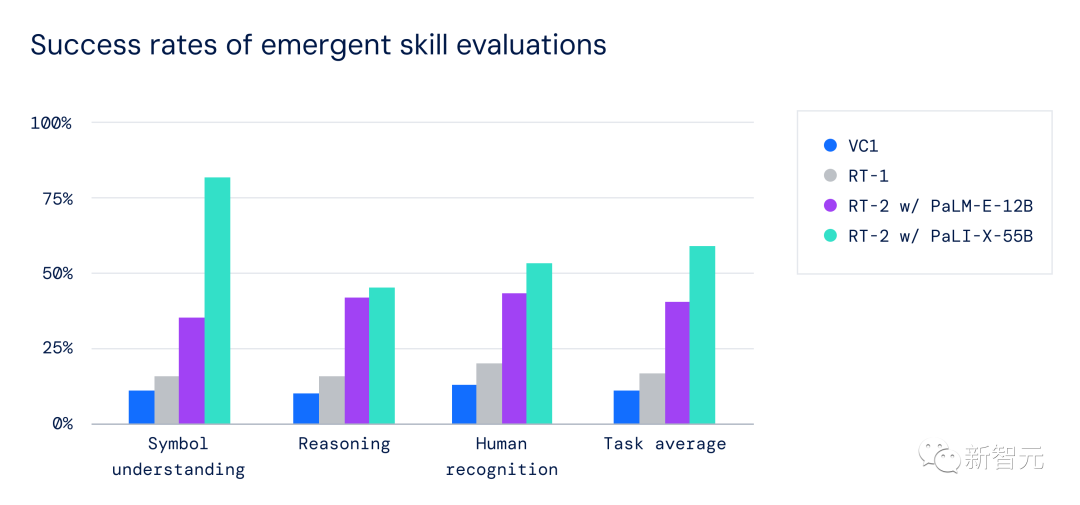

研究人員在在RT-2模型上進行了一系列定性和定量實驗,一共進行了6,000多次機器人試驗。

具體來講,谷歌團隊探索了RT-2的三項技能:

- 符號理解

- 推理

- 人類識別

以上的每項任務都需要理解視覺語義概念,以及執行機器人控制的能力。

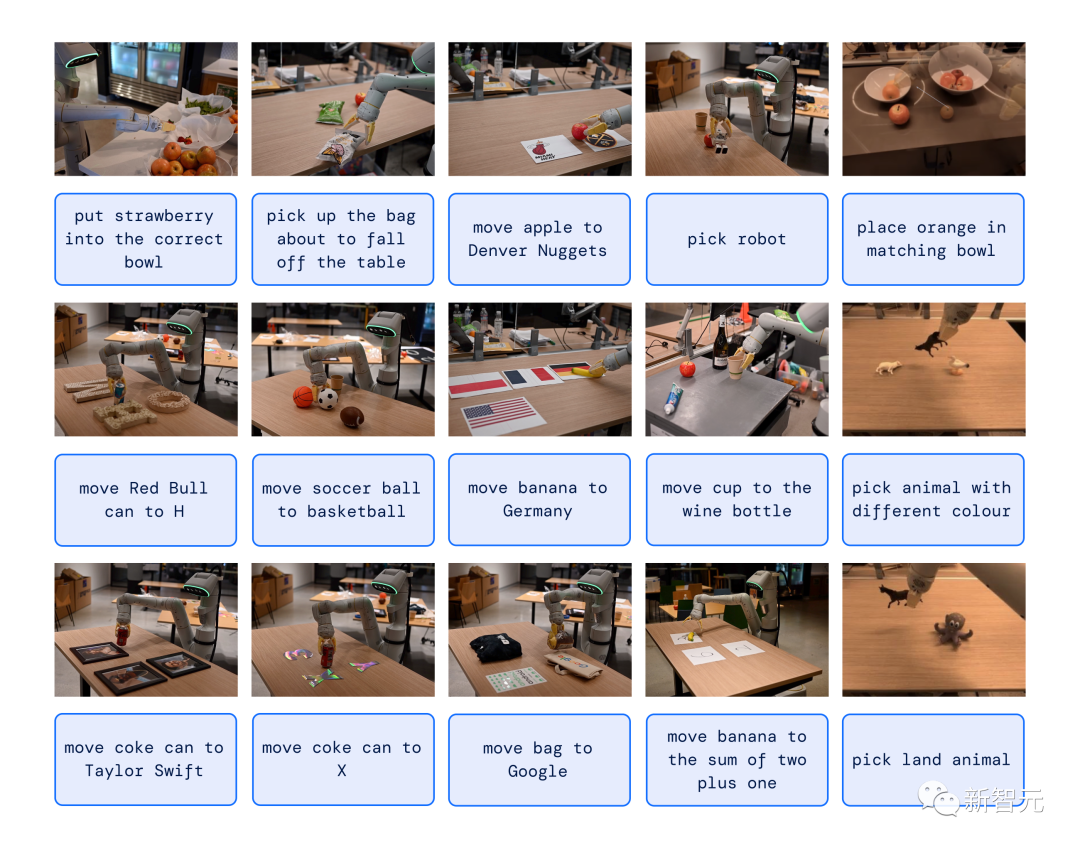

比如,讓RT-2去撿起從桌子上掉下來的袋子,或者將香蕉放到2+1之和的數字的命令。

其中要求機器人對數據中從未見過的物體或場景執行操作任務,將知識從基于網絡的數據轉化為可操作的。

數據中不存在的技能示例,需要通過網絡預訓練進行知識遷移

在所有類別中,研究人員觀察到,與之前的基線(例如之前的RT-1模型和Visual Cortex (VC-1) 等模型)相比,泛化性能提高了3倍以上,這些模型是在大型視覺數據集上進行預訓練的。

緊急技能評估的成功率:RT-2 模型優于RT-1和VC-1基線

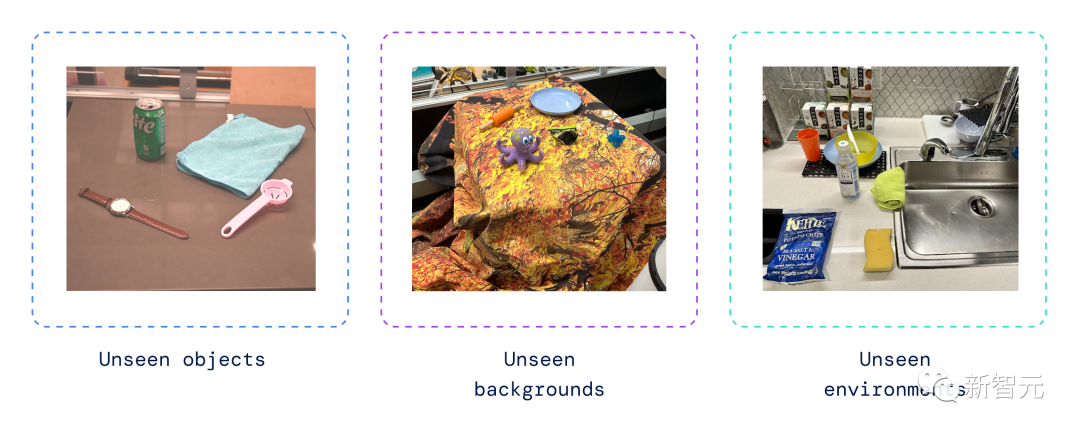

此外,研究人員還進行了一系列定量評估,首先是機器人數據中有實例的原始RT-1 任務,然后對機器人先前未見過的物體、背景和環境。

以上的任務可以讓機器人從VLM預訓練中學習泛化。

機器人以前未見過的環境示例

RT-2保留了數據中「看到」的原始任務的能力,并提高了機器人在以前未見過場景中的性能,從RT-1的32%提高到了62%。

研究人員還觀察到,與僅視覺任務預訓練的基線相比有顯著改進,例如VC-1和機器人操作的可重用表示 (R3M),以及使用VLM進行對象識別的算法。

RT-2 在可見的分布內任務上取得了高性能,并且在分布外未見的任務上優于多個基線。

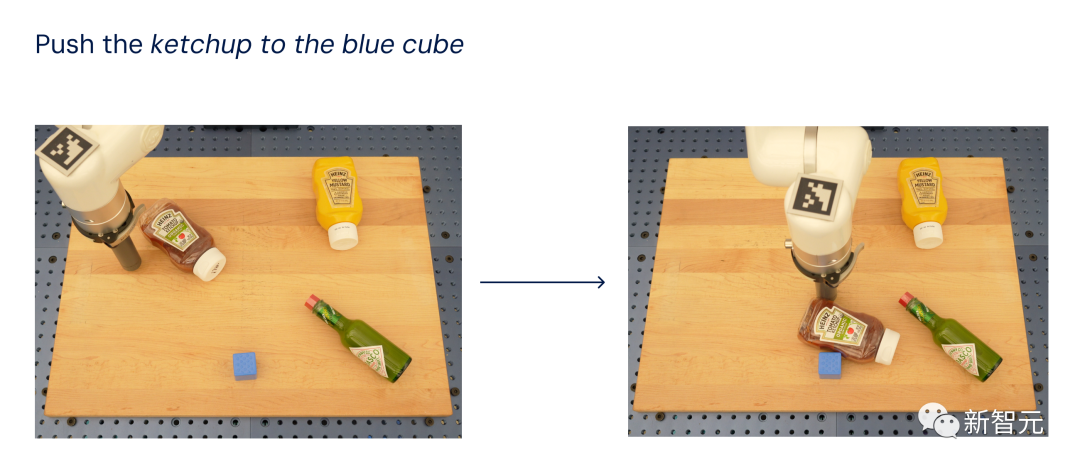

團隊還在開源語言表(Language Table)機器人任務套件上評估了模型,模擬中的成功率高達90%,比BC-Z(72%)、RT-1(74%)和LAVA(77%)等以前的基線模型有了大幅提高。

然后,他們還在現實世界中評估相同的模型,并展示了其泛化到新對象的能力。

如下所示,其中除了藍色立方體之外,沒有任何物體出現在訓練中數據集。

RT-2在真實機器人語言表任務中表現良好

受到LLM中使用的CoT方法的啟發,研究人員還將機器人控制與思維鏈推理相結合,以便能夠在單個模型中學習長期規劃和低級技能。

特別是,對RT-2的變體進行了幾百個梯度步驟的微調,以提高其聯合使用語言和動作的能力。

然后,研究人員還對數據進行了擴充,添加了一個額外的「計劃」步驟。

首先用自然語言描述機器人即將采取的動作的目的,然后是「動作」和動作標記。

示例如下:

思想鏈推理能夠學習一個獨立的模型,該模型既可以規劃長期技能序列,又可以預測機器人的動作

通過此過程,RT-2可以執行更多復雜的命令,這些命令需要推理完成用戶指令所需的中間步驟。

得益于VLM主干,RT-2還可以根據圖像和文本命令進行規劃,從而實現基于視覺的規劃。

通用機器人前景

RT-2的最新研究表明,視覺語言模型(VLM)可以轉化為強大的視覺語言動作(VLA)模型。

通過將VLM預訓練與機器人數據相結合,可以直接控制機器人。

基于大模型PaLM-E和PaLI-X的兩個實例化,RT-2提升了機器人的策略。

更重要的是,還帶來了顯著更好的泛化能力、以及應對突發問題的能力,繼承了網絡規模的視覺語言預-訓練。

RT-2不僅是對現有VLM模型的簡單,而有效的修改,而且還展示了構建通用實體機器人的前景。

該機器人可以推理、解決問題和解釋信息,以在現實中執行各種任務世界。

或許,機器人總動員中,那個聰明的瓦力離我們不遠了。