(來源:meta AI)

盡管效果相當粗糙,但該系統(tǒng)提供了生成式人工智能的早期前景,這也是今年掀起了巨大熱潮的從文本到圖像的人工智能系統(tǒng)的下一步。

meta 發(fā)布的 Make-A-Video 可能會促使其他人工智能實驗室發(fā)布他們自己的版本。這也引發(fā)了一些重大的倫理問題。

上個月,人工智能實驗室 OpenAI 開始向所有人提供其最新的文本到圖像 AI 系統(tǒng) DALL-E,另一家人工智能初創(chuàng)公司 Stability.AI 也推出了開源的文本到圖像生成系統(tǒng) Stable Diffusion。

但從文本到視頻的人工智能面臨著一些更大的挑戰(zhàn)。首先,這些模型需要大量的計算能力。

它們所需的算力,比大型文本到圖像的人工智能模型多得多,因為它們使用數(shù)百萬張圖像來訓(xùn)練,生成一個短視頻就需要用到數(shù)百張圖像。

這意味著,在可預(yù)見的未來,只有大型科技公司才真正有能力建造這些系統(tǒng)。它們的訓(xùn)練也比較困難,因為沒有與文本匹配的高質(zhì)量視頻數(shù)據(jù)集。

為了解決這個問題,meta 整合了來自三個開源圖像和視頻數(shù)據(jù)集的數(shù)據(jù)來訓(xùn)練其模型。

經(jīng)過標注的靜態(tài)圖像(標準文本圖像數(shù)據(jù)集)可以幫助人工智能掌握物體的名稱和樣子。

視頻數(shù)據(jù)庫可以幫助它理解這些物體如何在真實世界中行動。這兩種方法的結(jié)合有助于實現(xiàn)基于文本生成視頻并最終用于制作 Make-A-Video 模型。該模型的詳細介紹發(fā)表于一篇未經(jīng)同行評議的論文中。

艾倫人工智能研究所的計算機視覺研究科學(xué)家坦梅爾·古普塔(Tanmay Gupta)說,meta 的研究結(jié)果看起來很有前景。

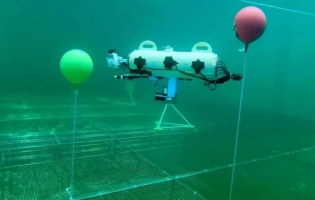

meta 發(fā)布的視頻顯示,該模型可以隨著相機的旋轉(zhuǎn)捕捉到三維形狀。該模型也對深度和光照的概念有著一定的理解。古普塔表示,許多細節(jié)和動作都做得很不錯,而且令人信服。

然而他也補充說,“技術(shù)層面仍有很大的進步空間,特別是如果這些系統(tǒng)要用于視頻編輯和專業(yè)內(nèi)容創(chuàng)作,比如我們?nèi)匀缓茈y在物體之間建立復(fù)雜的交互模型。”

在使用“藝術(shù)家用畫筆在畫布上繪畫”這段文字生成視頻時,我們可以看到畫筆在畫布上移動,但畫布上的筆觸并不真實。古普塔說:“我希望看到這些模型能夠成功地產(chǎn)生一系列的互動,比如‘男人從書架上拿起一本書,戴上眼鏡,一邊坐下來一邊喝咖啡’。”

就 meta 而言,它將這項技術(shù)視為是“為創(chuàng)作者和藝術(shù)家打開新的機會”。

但隨著技術(shù)的發(fā)展,人們擔心它可能會被用來作為一種制造和傳播虛假信息和深度造假的強大工具。這可能會使區(qū)分網(wǎng)絡(luò)內(nèi)容的真假變得更加困難。

合成媒體專家亨利·阿杰德(Henry Ajder)說,meta 的模型提高了生成式人工智能的技術(shù)和創(chuàng)造性,但同時也帶來了風(fēng)險,因為“生成視頻而不是靜止圖像可能造成獨特的傷害”。

古普塔說:“至少在今天,創(chuàng)造出人們可能相信的虛假內(nèi)容需要花費一些努力。但在未來,可能只要點幾下鼠標,就有可能產(chǎn)生誤導(dǎo)性的內(nèi)容。”

制作 Make-A-Video 的研究人員過濾掉了包含攻擊性的圖片和文字,但他們使用了由數(shù)以百萬計的圖片和單詞組成的數(shù)據(jù)集,幾乎不可能完全刪除所有有偏見和有害的內(nèi)容。

meta 的一位發(fā)言人表示,他們還未計劃向公眾提供該模型,“作為本研究的一部分,我們將繼續(xù)探索進一步完善模型和降低潛在風(fēng)險的方法。”